Krótko. Jesteśmy już bardzo blisko momentu, w którym elementy elektroniczne staną się tak małe, że do głosu zaczną dochodzić efekty kwantowe.

Nie będę ściemniał – początkowo planowałem zupełnie inny tekst, poświęcony jednemu z zagadnień funkcjonowania komputerów kwantowych. Jednak z uwagi na istną lawinę nowych informacji, stwierdziłem, że muszę na razie spasować i najwyżej wrócę do tematu w przyszłości. W zamian proponuję rozważenie pytania pokrewnego. Zastanówmy się nad tym, jak może wyglądać przyszłość komputerów konwencjonalnych. Gdzie leży granica potencjału współczesnych urządzeń elektronicznych i z czego właściwie ona wynika?

Żeby to wyjaśnić, przyjrzyjmy się pokrótce zasadzie działania naszych procesorów. Cały sposób “rozumowania” komputera oparty jest o przetwarzanie bitów, stanowiących najmniejsze możliwe do wyodrębnienia porcje informacji. Na poziomie logicznym jeden bit sprowadza się do wyboru między dwoma opcjami, jak: prawda i fałsz, tak i nie, orzeł i reszka – bądź cyfrowo – jeden i zero. To prymitywny, ale niezwykle użyteczny i uniwersalny system, łatwy do zaimplementowania w niemal każdym mechanizmie. Jeśli umówimy się, że wyłączony przełącznik oznacza zero, a włączony jeden, to możemy skutecznie przesyłać lub zapisywać dane w języku binarnym.

W elektronice rolę takich przełączników pełniły początkowo nieporęczne lampy elektronowe, z powodzeniem zastąpione przez tranzystory. W rzeczy samej, cały rozkwit branży elektronicznej, od dekad sprowadza się do jak najgęstszego upychania w układach scalonych maleńkich tranzystorów, tak aby mieliły niezliczone ciągi zer i jedynek, z coraz większą wydajnością.

Stąd uzasadnione wydaje się pytanie, jak długo będziemy mogli bezproblemowo pomniejszać i ścieśniać elementy elektroniczne? Niestety wiele wskazuje na to, iż kres intensywnej miniaturyzacji nadejdzie już niebawem.

Trzeba przyznać, że jak dotąd tempo rozwoju mikrochipów było doprawdy imponujące. Doskonale pamiętam mój “wypasiony” PC z 2002 roku wyposażony w Pentium 4 z taktowaniem 1,6 GHz i 256 MB pamięci RAM. Minęło zaledwie kilkanaście lat, a wydajniejszymi bebechami dysponuje mieszczący się w dłoni, przeciętny smartfon.

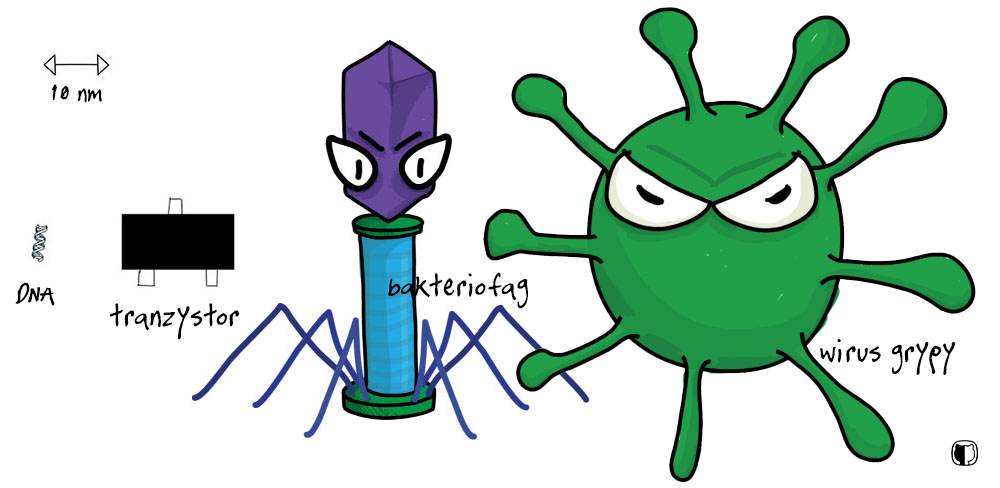

Skąd taka różnica? Pomyślcie o tym, że pierwszy procesor Pentium zawierał 3 miliony tranzystorów o wielkości 0,8 mikrometra (0,0008 milimetra). We współczesnych urządzeniach obecne są tranzystory 14 lub 10 nanometrowe (0,00001 milimetra), a gdzieniegdzie pojawia się już technologia 7 nm (jest w tym co prawda trochę marketingu, bo w realnie urządzenie jest ciut większe, ale to nadal kwestia nanometrów). Żebyśmy mieli jasność, w jakiej skali operujemy: to zaledwie kilka grubości helisy DNA i dziesięć tysięcy razy mniej niż długość ludzkiego plemnika!

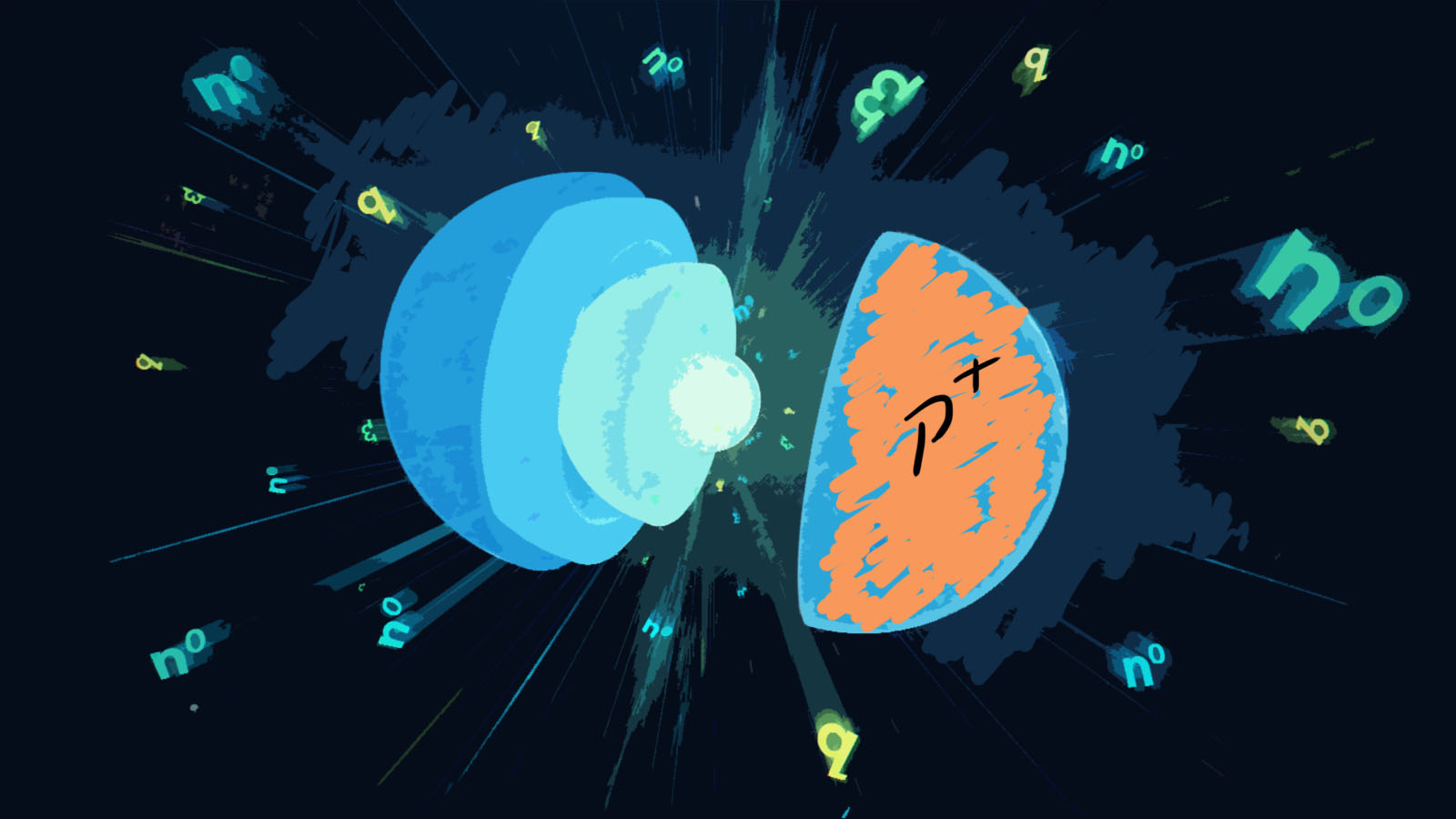

Co będzie dalej? IBM już przedstawił procesor w standardzie 5 nm i przekonuje, że można ten wynik jeszcze poprawić schodząc do 3 i 2,1 nm. Mniej więcej w tym miejscu, współczesna elektronika trafi na przeszkodę czysto fizyczną. Operując w skali de facto pojedynczych molekuł, szyki inżynierom zaczną mieszać prawidła mechaniki kwantowej. Pamiętajmy, że podstawą funkcjonowania naszych urządzeń jest przepływ prądu i zjawisko półprzewodnictwa. Korzystając z tego dobrodziejstwa, elementy elektroniczne mogą zależnie od warunków i naszych potrzeb, przewodzić prąd lub stawić mu opór.

Ale jak zachować pełną precyzję w przetwarzaniu zer i jedynek, kiedy wszystkie tranzystory są tuż obok siebie? Jak to osiągnąć, gdy bariery powstrzymujące ładunki elektryczne mają grubość dosłownie paru atomów?

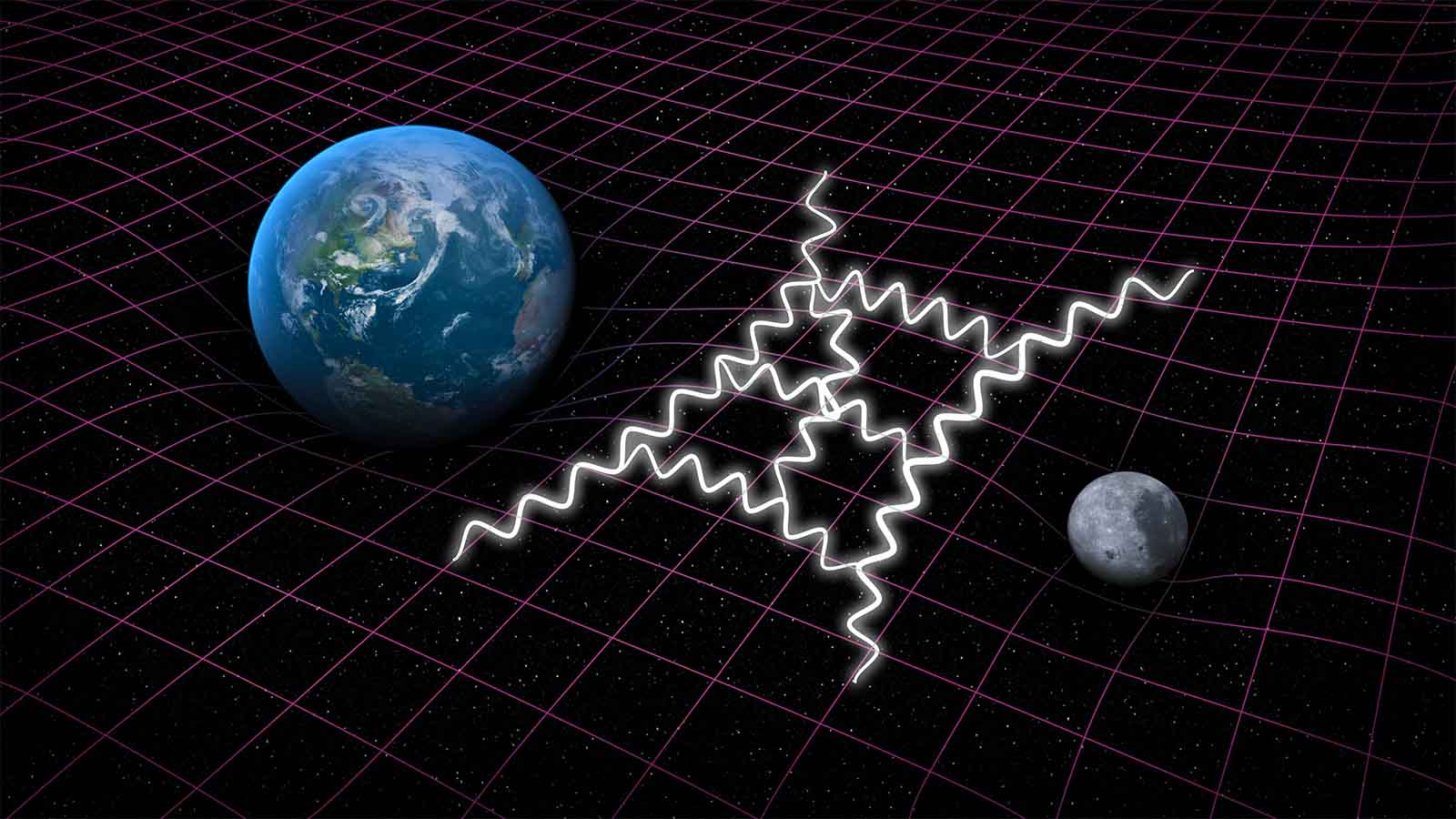

Główną zmorą konwencjonalnych mikrochipów jest zjawisko zwane tunelowaniem kwantowym. (W tym miejscu muszę się pokajać, ponieważ jakimś cudem na łamach Kwantowo nie pojawił się dotąd żaden obszerniejszy artykuł na ten temat. Rzecz do nadrobienia). Podobnie jak w przypadku innych dziwactw mikroświata, tak i tu o wszystkim decyduje nieznośna losowość i prawdopodobieństwo. Wyobraźmy sobie, że jedziemy na deskorolce i mamy przed sobą do pokonania pagórek. Odpychając się nogą dostarczamy sobie energii i możemy wtoczyć się na szczyt. Jednak jeśli energii będzie zbyt mało – tj. nie odepchniemy się dość mocno – zatrzymamy się i zsuniemy z powrotem w dół.

Tak to działa w świecie fizyki klasycznej. Mechanika kwantowa pozwoliłaby na coś zupełnie nieintuicyjnego: zaistniałaby pewna szansa na to, że znikniemy i pojawimy się z drugiej strony przeszkody. Jak na pewno wiecie, losem cząstek elementarnych rządzi Heisenberg i jego zasada, wedle której nie da się z całą pewnością określić położenia i pędu cząstki. Istnieje również niezerowe prawdopodobieństwo, że opisywana przez funkcję falową cząstka o nieokreślonej energii i lokalizacji, zignoruje niewielką przeszkodę i przebije się na drugą stronę.

Efekt jest taki, że lada chwila skonstruujemy układy na tyle drobne, że ładunki elektryczne zaczną ignorować cieniutkie bariery, przeskakując tam gdzie nie powinny. Z pewnym prawdopodobieństwem zamiast zera, może wyskoczyć jedynka – a na to nie możemy sobie pozwolić.

Zapewne obiło wam się o uszy prawo Moore’a. Zgodnie z nim, liczba tranzystorów w mikroprocesorach i co za tym idzie moc obliczeniowa komputerów, powinna się podwajać mniej więcej co dwa lata. Trzeba przyznać, że proroctwo prezesa Intela okazało się zdumiewająco poprawne. Goordon Moore miał jednak rację nie tylko co do optymistycznej wizji bujnego rozkwitu elektroniki, ale również trafnie przewidział moment jego załamania. Jako cezurę lat tłustych dla branży obstawił rok 2020. Rzeczywiście, dynamika miniaturyzacji już znacznie osłabła, zaś inżynierowie znajdują się zaledwie o kilka kroków od wyciśnięcia z konwencjonalnych rozwiązań maksimum efektywności.

Oczywiście nie oznacza to zupełnego wyhamowania postępu. Jeszcze przez wiele lat będziemy świadkami gimnastyki z udziałem nowych materiałów, kształtów i struktur (patrz: tranzystory FinFET), jak również prób wykorzystania nieznośnego tunelowania na naszą korzyść (tranzystory TFET). Nie zmienia to jednak faktu, że potencjał klasycznych komputerów posiada wyraźne ograniczenia, a ich dalsza ewolucja nie będzie już tak gwałtowna jak kiedyś.